此次学习会的主题是强化学习和Echarts。

强化学习是机器学习的一种类型,而Echarts则能够绘制各种图表。

由于这次的主题不尽相同,因此以下将分别进行解释。

什么是强化学习

强化学习是一种学习方法,可总结为以下内容。

为了获取最大

报酬而学习

行动。

那么,

报酬和

行动是什么样的呢?

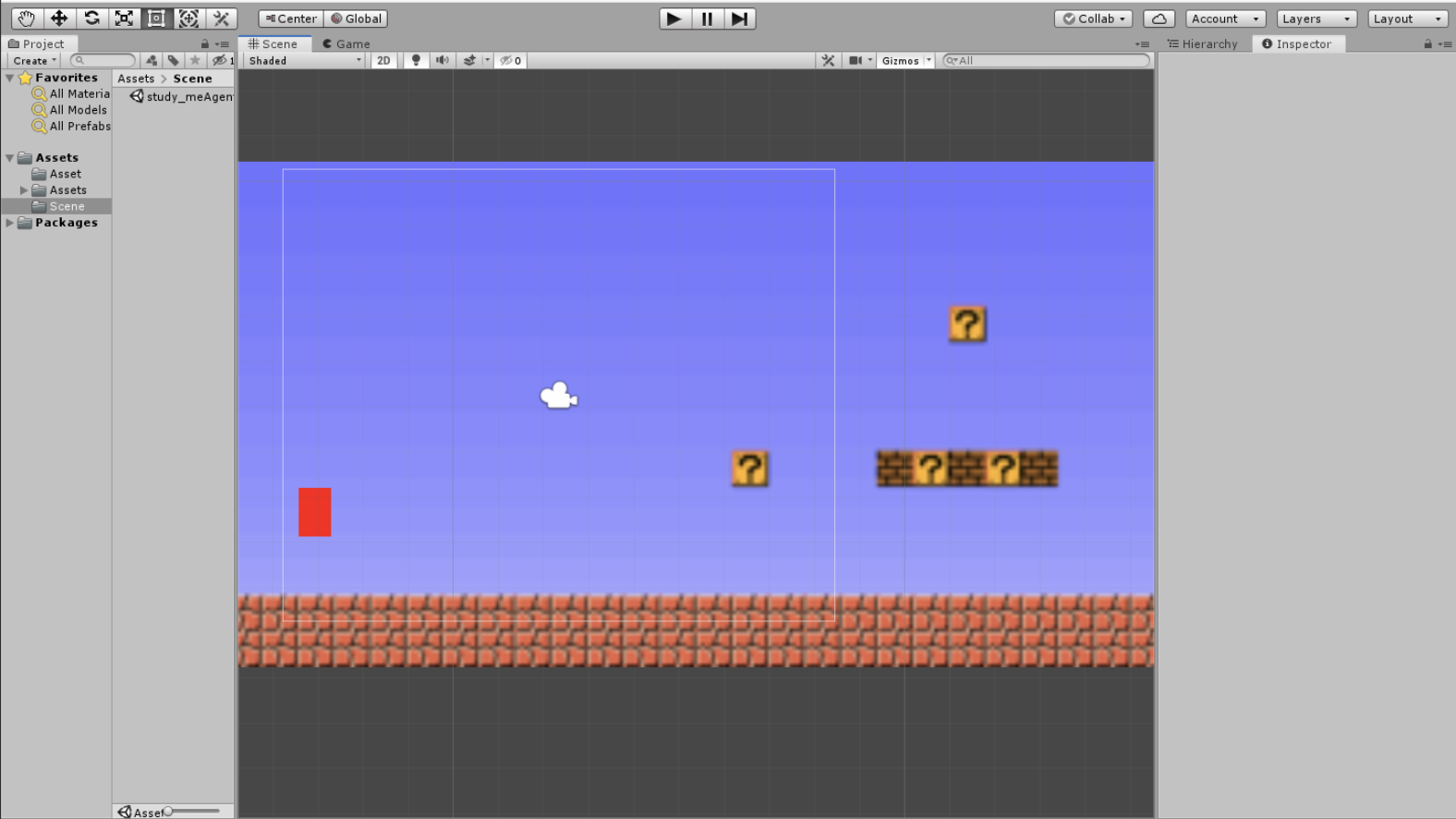

以下是本公司的工程师编写的程序,其中通过

红苹果色的

几何体(以下称作马里奥),我想对

报酬、

行动、

强化学习进行解释。

テレッテッテテッテーテンッ♪

报酬和行动

我们首先考虑

报酬。

一般情况下、所谓报酬,就是「量化表示的对象的目的」。

带着这种想法我们再来考虑马里奥的报酬。

马里奥的目的是到达画面右侧的目的地。

因此,换句话说、马里奥可以通过离开自己的起点达成达到目的地的目标。

这里定量地表示,就是

「马里奥到出发点的距离(x轴的正方向)越大,就越接近目的地」。

报酬也就是,

马里奥与出发点的距离(x轴的正方向)。

接下来考虑

行动。

行动以字面意义理解就OK,即「量化表示的对象的动作」。

没有经过学习的马里奥会向左右方向随机运动,这里用量化为「选择左、右的比率」。

也就是如下所说,

行动:马里奥选择左和右的概率。

学习结果

正如文章开头所述,强化学习是为了使

报酬最大化的方式学习

行动。

如果按上述应用报酬与行动,即表示如下:

为使「马里奥到出发点的距离(x轴的正方向)」去学习「马里奥选择左、右的比率」。

马里奥经过一定的时间后到达的距离。或者说,就是按照到达点的距离计算报酬而进行学习。

根据好的结果(距出发点距离较大)或者坏的结果(距离出发点的距离较小)来选择最合适的选择左、右的比率。

人类也是如此学习的呀。

下面的视频展示了学习的开始阶段。

学习开始时,选择左右的比率接近1:1,即还没有学习到向哪个方向行动比较好。

这是左右不分的阶段。

因此,不会走太远。

经过一定程度的学习,最终马里奥可以像如下所示的方式移动。

与学习初期进行比较,更加接近最终的目的地了。

顺便说一下,管道碰撞判断将在下次进行说明。

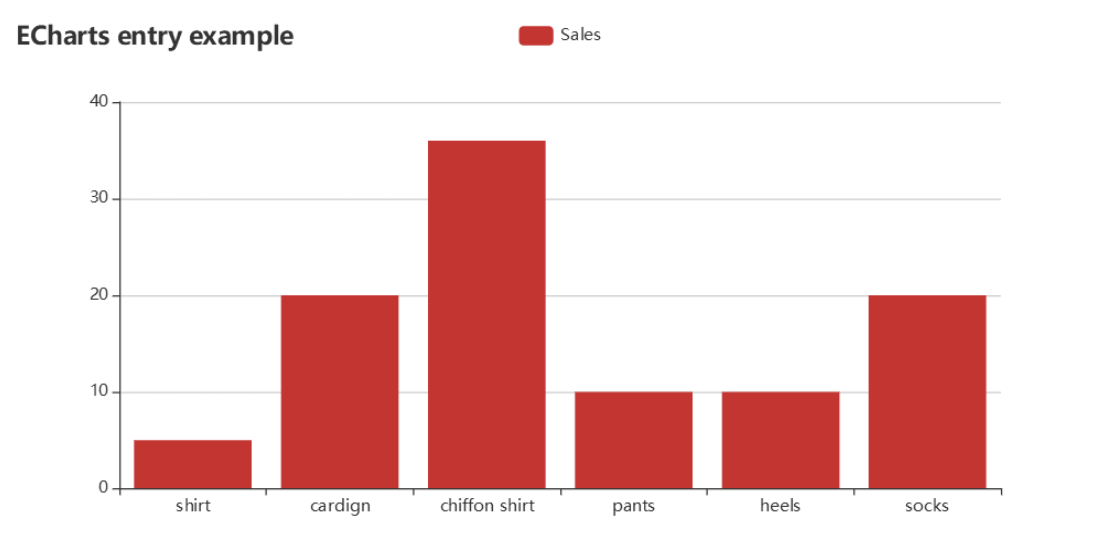

Echarts

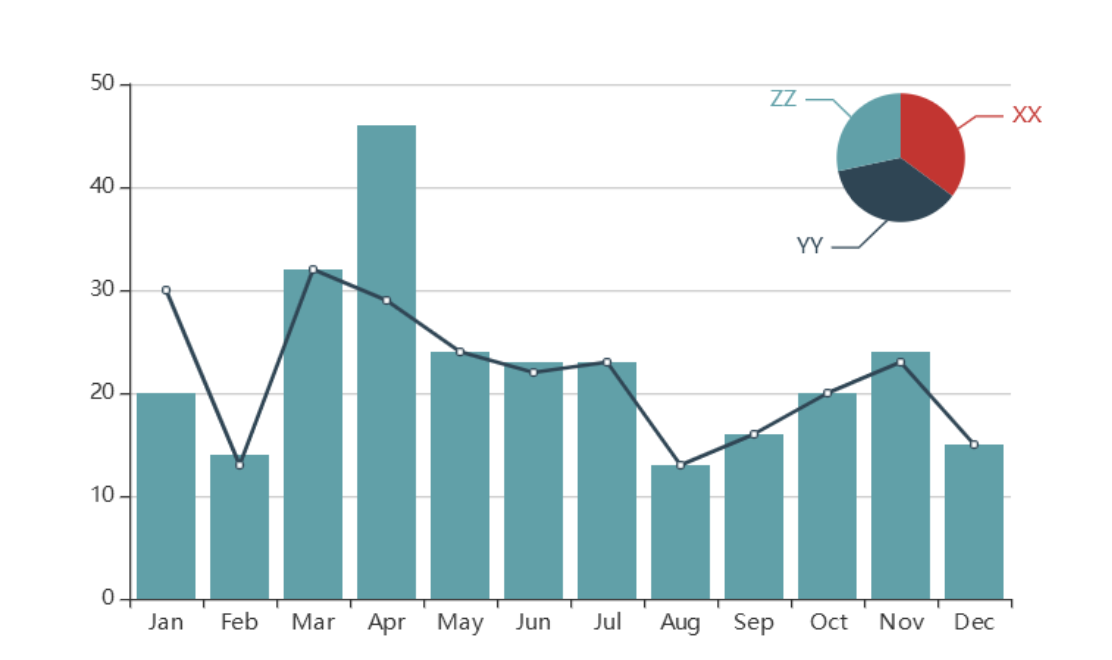

Echarts是由Baidu提供的HTML5/JavaScript开源软件(MIT License),可以绘制多种图表。

从基本的条形图到各种图表的组合。

除了上面的图标之外还有很多种样式可供选择,也许可以直接找到需要的图表?!

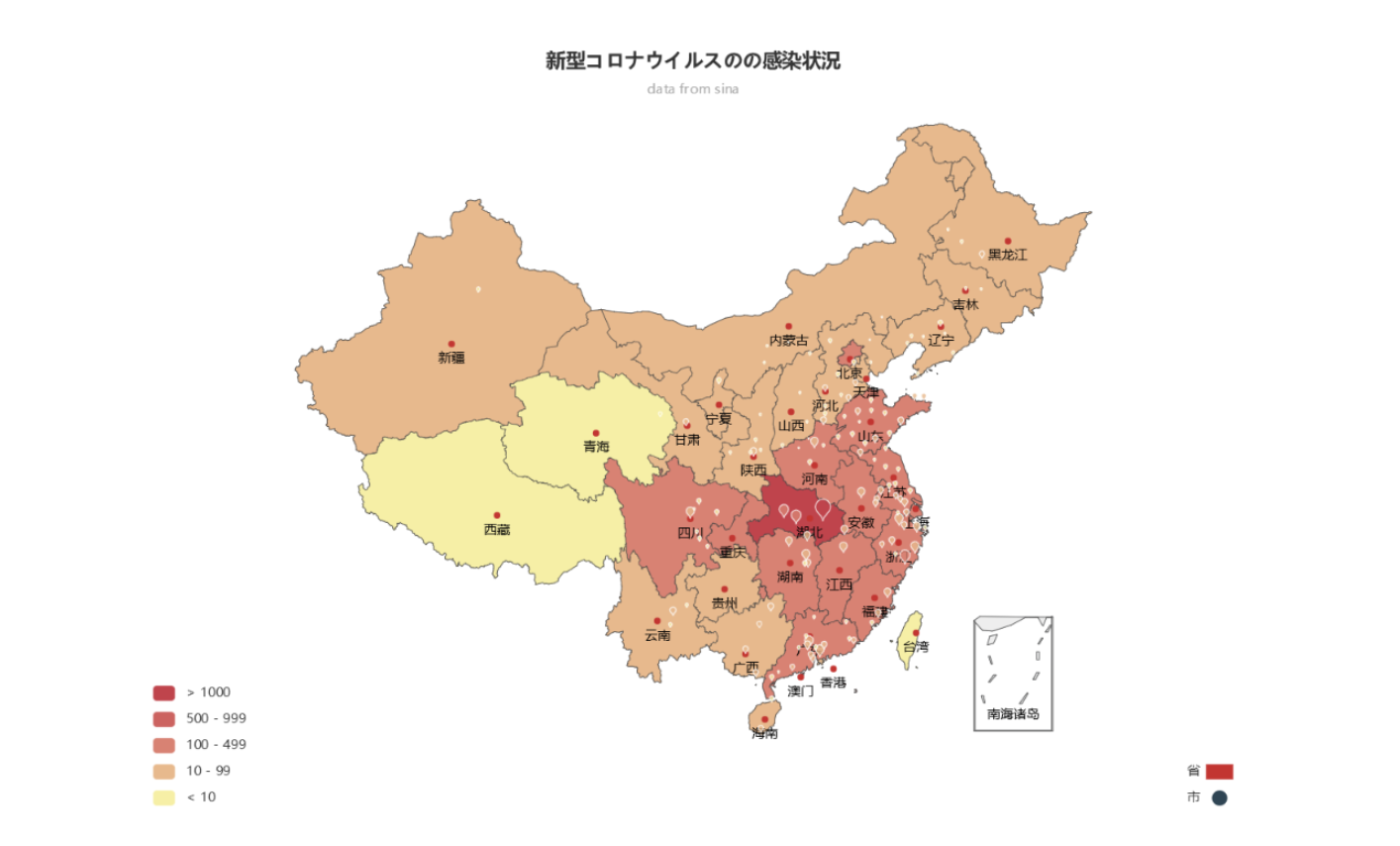

本公司的工程师使用Echarts绘制了新型冠状肺炎感染状况的图表。(2020年1月下旬)

现在的情况可以在

此处确认。

接下来,请务必再制作一个日本版的呀!(祈祷希望不要出现红色的区域。)