以着眼于在RNN中使用的过去的重要点的方法对每个隐藏层进行加权。

通过由context vector加权,识别各单词应参考的重要单词,来创建可说明的AI。(为了让AI的关注点可视化)

2020年06月04日

5月29日,也是5月最后一个工作日,举办了第13次的学习会。

主题是「WebRTC」和「AI与艺术」。

能够在浏览器中实现通信的WebRTC和近年来引发关注的关于AI的艺术创作

此次由今年春天新入职的两位新人进行了分享。

WebRTC(Web Real Time Communication)是在Web浏览器中以实现实时通讯为目的的开源软件。

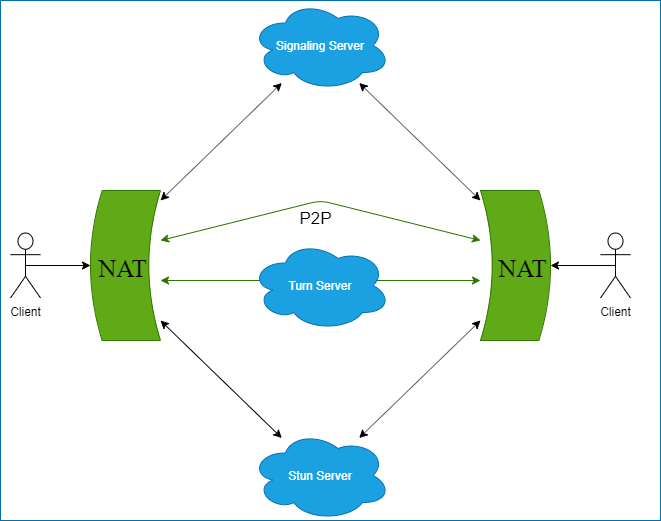

为了实现这一目的,使用了名为P2P与ICE的技术。

原本P2P(Peer-to-Peer)通信,是不需要特定的服务器作为中介,直接进行端对端通信的方式。

一般来说,互联网上有作为中心的服务器,服务器将同样的客户端进行了连接。也就是可以想到的client-server型的网络。

但是,P2P通信是不通过服务器,客户端之间直接进行通讯的方式。

在P2P中,需要知道想要连接的对方的信息,也就是终端IP地址的信息。

在这里,大多数场合下,一般会预先设置一个为了进行相同通信者之间的信息交换的服务器。

这就是Signaling服务器

顺便说一下,在WebRTC中,Signaling服务器与客户端之间的通信方式不需要特别规定。

经过这个Signaling服务器,客户端就能够收发与通信对象连接的信息了。

实际上,为了实现客户端之间的通信,WebRTC中使用了叫做ICE的框架。

ICE是与寻求通信的客户端之间以各种设定的网络进行尝试连接的框架。

比方说,除去属于同一个网络的特殊情况,有相同通讯方之间配置了各种其他NAT的情况。这种情况下,需要进行跨NAT的通讯。

为了实现ICE,需要有Stun服务端和Turn服务端。

Stun服务器,发送请求,从外部(互联网)可查看自己返回的IP的服务器。

首先,在ICE中,使用Stun服务器返回的IP,可以进行相同客户端之间的通讯。

但是,在仍然不能连接的情况下, 则由Turn服务器尝试连接,以后将全部转为Turn服务器执行通讯。

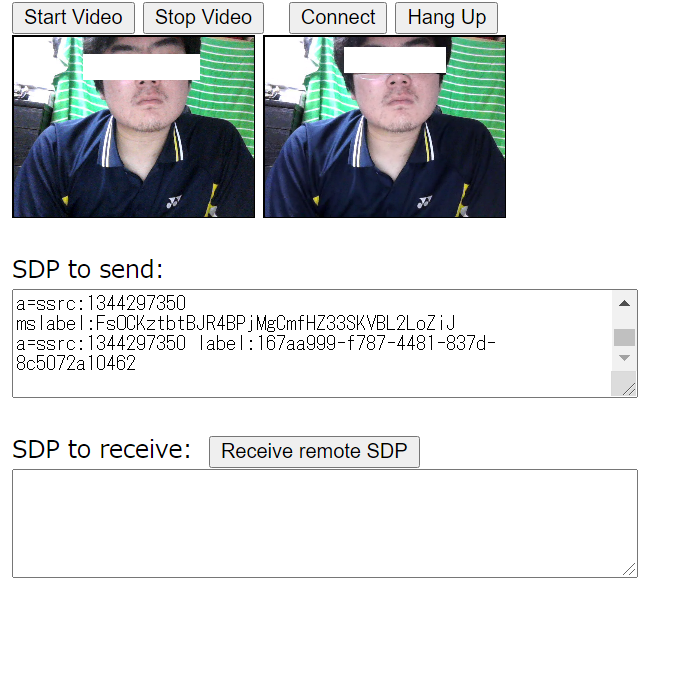

在学习会中,员工使用WebRTC进行了实机演示。

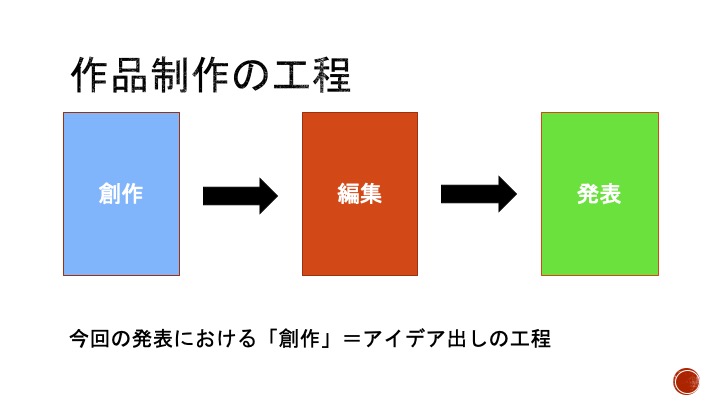

这里,假定作品的一般创作流程为[创作]->[编辑]->[发表]。

相应的音乐流程为->[(作词)作曲]->[编曲]->[演奏/发布音源等]。

与各个阶段相关的AI服务已经存在了,有以下的内容。

指定风格,曲子的气氛,长度就可以自动生成乐曲。

面向制作BGM,已经被大型通讯公司路透社的服务所采用。

使用在音乐中应用的一系列机器学习算法的针对日语的自然语言处理技术的自动编曲AI。

提供了IOS的手机应用。在应用版中,通过AI学习和分析历史上的600首热门歌曲作为数据集,在旋律上添加了特征量来生成。

罗马教皇访日活动“POPE IN JAPAN 2019”的官方主题曲《PROPTECT ALL LIFE~时间的印记~》的作曲中被应用到。

使用专门的键盘更甚者说是根据音乐厅的旋律进行选择后,使用实现训练好的模型进行自动编曲。(不是AI作曲)。

使用GAN生成伴奏,能够使用独立的模型进行制作。

在乐曲的制作以外,还提供了通过AWS Deep Composer进行机器学习的相关学习的【学习胶囊】的相关服务。

Music Transformer是Google公司开发的,用于MIDI数据(音乐的演奏信息数据化的数据)生成的AI。

由于采用了不使用RNN的Self-Attention,自然语言处理AI—Transformer(在google翻译中使用)的表现出了压倒性的性能。

所谓Transformer就是【在过去的自然语言处理(NLP)中经常使用的循环神经网络(RNN)或者是卷积神经网络(CNN)】替换为【Self-Attention-Layer】。

以着眼于在RNN中使用的过去的重要点的方法对每个隐藏层进行加权。

通过由context vector加权,识别各单词应参考的重要单词,来创建可说明的AI。(为了让AI的关注点可视化)

是处理时间序列数据的神经网络,是将从上一个单词中提取的权重承继到下一个单词的结构。

适合分析与前后数据有关的时间序列数据。

使用Transformer和提供的MIDI数据,能够根据之前的MIDI数据进行预测,作曲。

音乐中有叫做小节的反复结构和主题的再利用,Transformer不只是直接参考前面的内容,在长的跨度下也可以作为参考,能够生成更像音乐的数据。

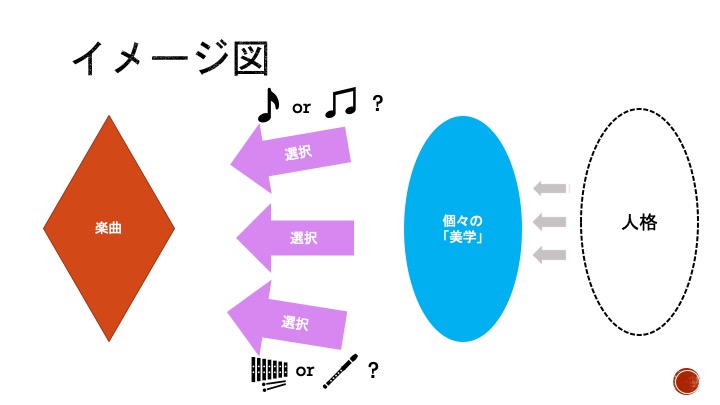

最后,介绍来自社员的关于AI作曲的考察。

顺便说以下,现在AI可以根据有审美感的个人(或者说是团体)的数据进行学习,数据原本的【美学】也可以被再现(比如AI创作的披头士风格的乐曲等)。