2024年05月08日

どうもこんにちは、Kです。

今回は3月末に社内で行われた勉強会についてです。

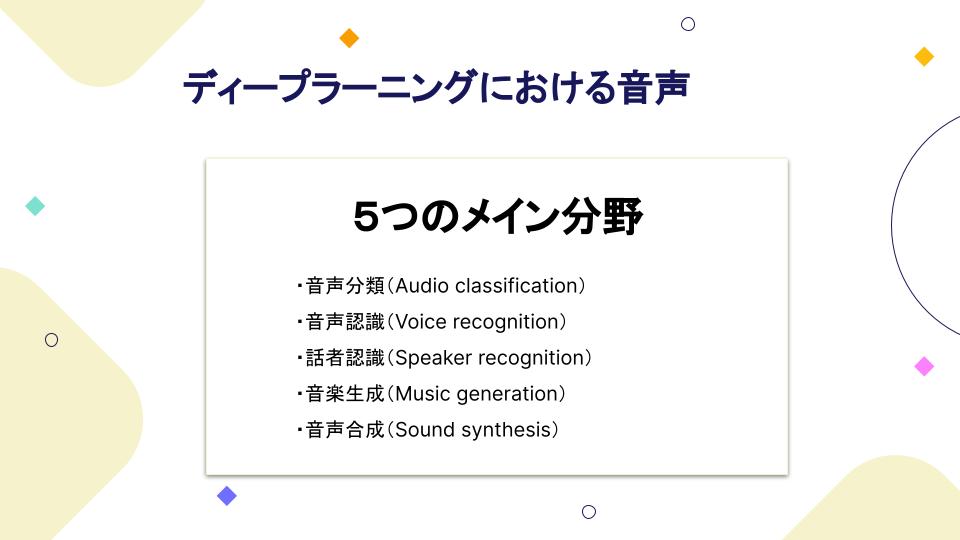

今回はペルソナで製品導入に向けたデザイン と AI・MLにおける音声処理・話者認識モデルの話です。早速見ていきましょう〜

まず、ペルソナで製品導入に向けたデザインについてです。

自社のECサイトパッケージ「PavoMart」のサービスについて社内で共有しました。

企業間の注文のやり取りをオンラインでできるプラットフォームで、

発注者はこのプラットフォームで希望の商品を注文できます。

そして、受注者はプラットフォームと連携されたSalesforceで注文内容を確認できます。

PavoMartとは、簡単に言うと「カスタマイズ可能なtoB向け Salesforceで管理できるECサイト」サービスです。

そもそも「PavoMart」の「Pavo」はクジャクという意味で、そこからはマジカルバナナのように連想を続け、

「クジャク」→「カラフル」→「沢山の色」→「沢山」→「沢山の商品」→「沢山の商品を取り扱うECサイト」と

少し強引なところもありますが…。

そして クジャクは羽を広げるととてつもなく大きく見えますよね、その部分からも取っていて クジャクが羽を大きく広げる様に、

このサービスを利用するお客様がビジネスを広げれる様に…という意味が込められています。

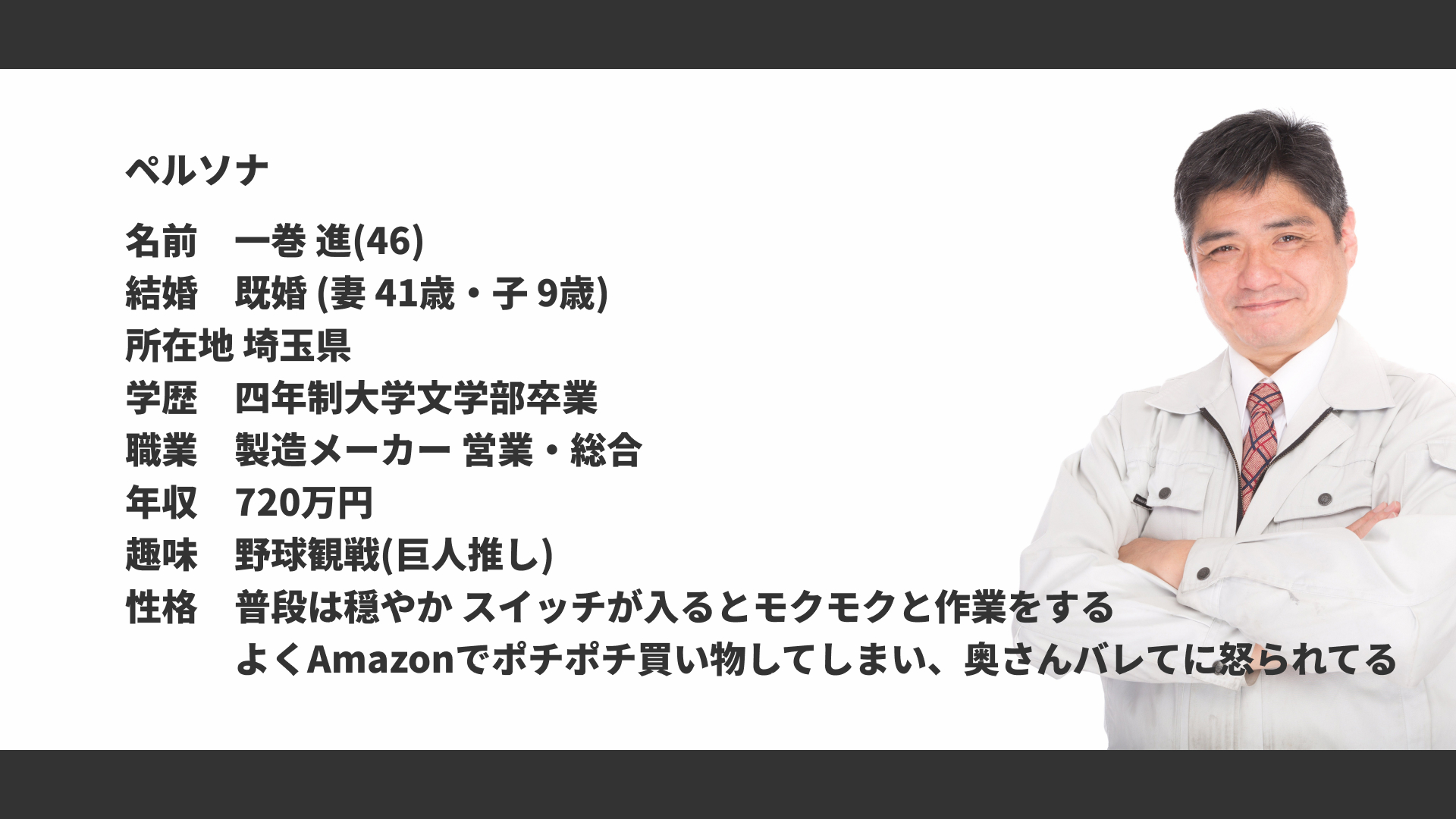

今回 作成した、簡単なペルソナ。

「ペルソナ」とはターゲットをより具体的な人物として落とし込んだものです。

お客様とヒアリングする段階で、そのサイトを利用するターゲットを絞ります。

その後、上げてもらったターゲットを更に具体的にする為に、

「こういう人、いるよね」レベルの ユーザーイメージ、ペルソナを作成します。

そのユーザーイメージを開発するメンバーに共有することにより、必要な機能や求めるデザインを確率することが容易になります。

チームのメンバーの様々な世代や性別 等がありますから、ペルソナを軸にイメージを固めるのは大切です。

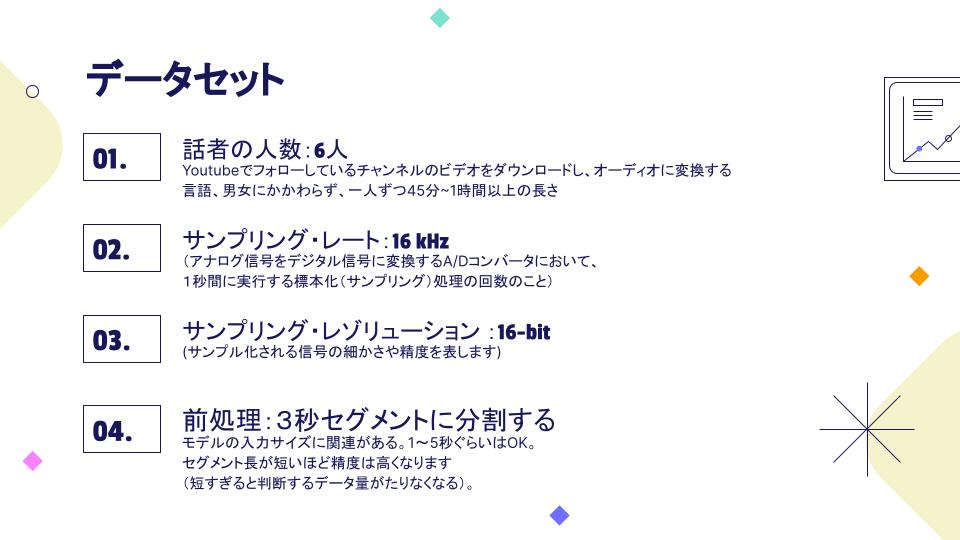

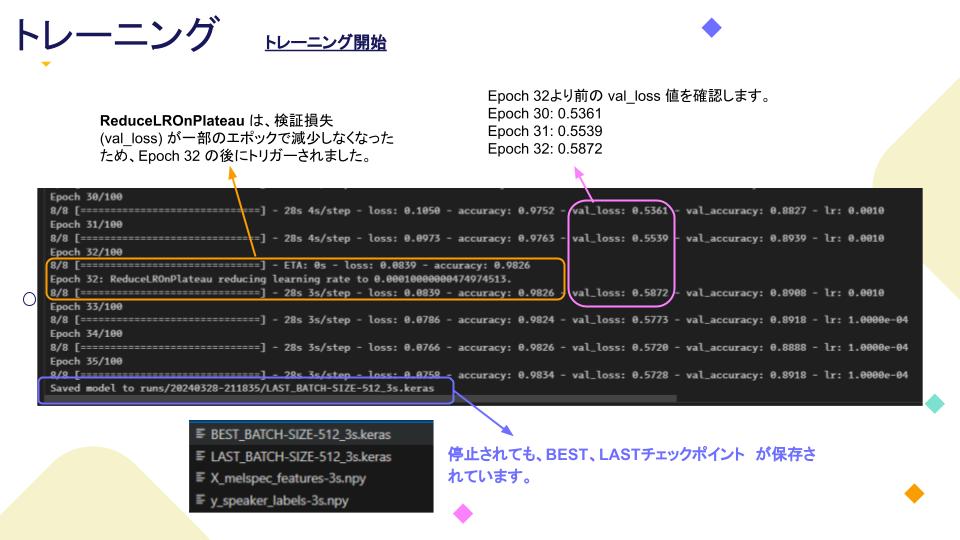

モデル作成できましたので、トレニンーグに進みます。トレニンーグするには、「EarlyStopping」、「ModelCheckpoint」、「ReduceLROnPlateau」というコールバックを使います。

EarlyStoppingのpatience値は10、ModelCheckpointはsave_best_only、ReduceLROnPlateauのfactorは0.1、patienceは7に設定します。

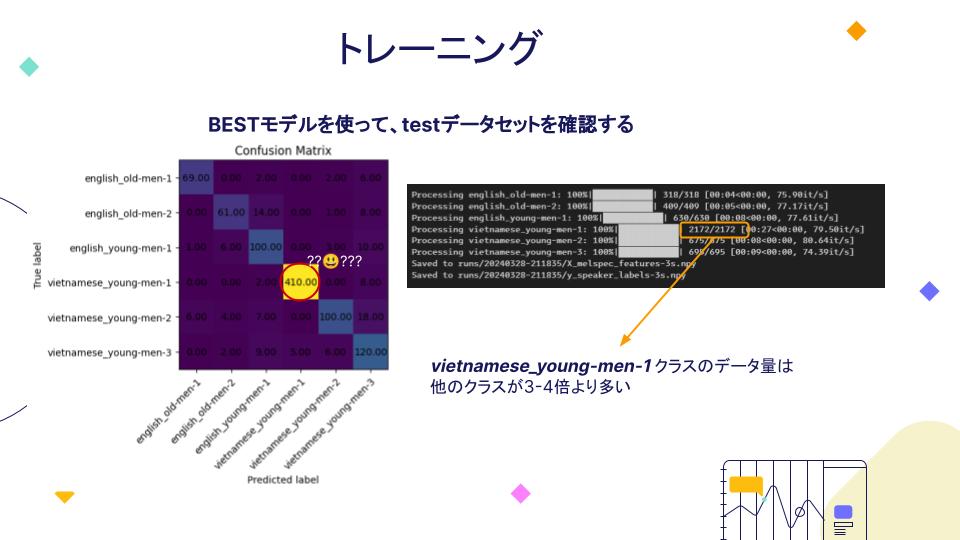

トレニンーグしたモデルをテストデータセットで確認すると、非常に良い感じですが、1つのクラスのデータセット量はほかのクラスよりかなり多いので、Confusion Matrixに異常なところが出てきました。

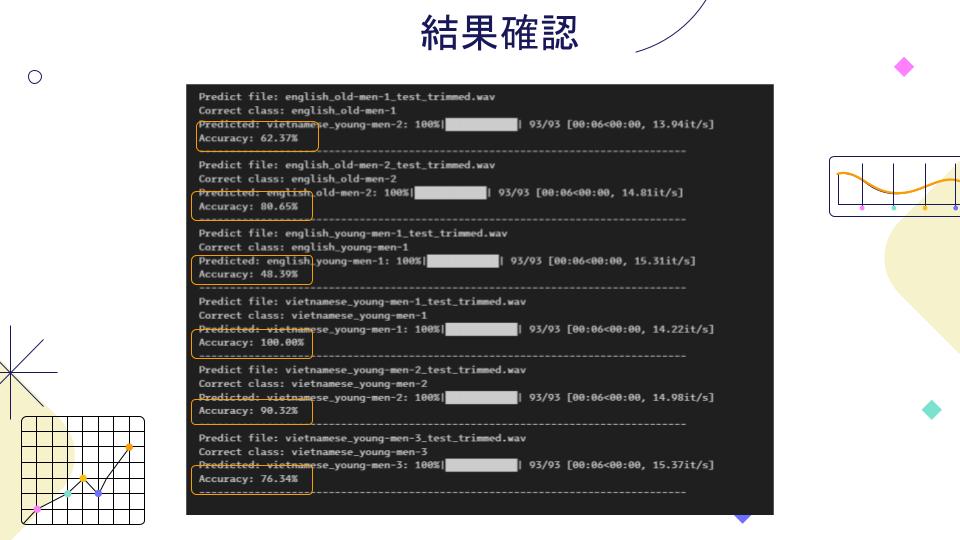

検証用データを作成して、overlappingという技術を使って、トレニンーグしたモデルで検証判定しました。

トレニンーグデータセットも、検証用データにもまだ色々なところに騒音、雑音などが混んでしまったので、

総合的な制度が下がってしまいました。

これからの精度向上には、まずデータセットの処理は騒音、雑音、沈黙ギャップなどを切り捨てが必要で、

各クラスのデータ量を等しくする必要となります。

今月の勉強会は以上になります、ではまた。